Det globale Internett er blitt et uoversiktlig sammensurium som att på til vokser både svært raskt og nærmest uregulert. Samtidig blir den samfunnsmessige betydningen stadig større. Det innebærer at sikkerhet, pålitelighet, sårbarhet og videre utbygging av nettet er utfordringer både nasjonalt og overnasjonalt.

Ovenstående avsnitt oser av banalitet. Men få har hittil våget å spørre seg om det hefter noen farer ved den pågående utviklingen. Et unntak er EUs organ for IT-sikkerhet, Enisa. De har nylig utgitt rapporten Resilience of the Internet Interconnection Ecosystem, som er tilgjengelig i full versjon (pdf, 238 sider) og i kort versjon (pdf, 23 sider).

Rapporten er fascinerende lesing, ikke bare fordi den kartlegger mulige katastrofescenarier og foreslår et rammeverk mulige reguleringsinitiativ fra EUs side – med sterke advarsler mot overilte og ugjennomtenkte utspill – men også på grunn av beskrivelsen den gir av hvordan nettet faktisk er oppbygget og hvilke følger den pågående utviklingen kan få.

Særlig interessant er påvisningen av strukturelle endringer knyttet til framveksten av et fåtall dominerende nettverk bygget opp med tanke på å levere spesifikt innhold, og av at de største operatørene – de som framfor alt sørger for å formidle trafikk for andre – opplever store økonomiske tap med sin nåværende forretningsmodell.

Enisa påviser at de som i hovedsak håndterer transitt ikke kan regne med å tjene på investeringer som ville gjort nettrafikken generelt sett raskere og selve Internett mer motstandsdyktig mot katastrofer og kriminell virksomhet.

Følgelig gjør de ikke slike investeringer. Hittil har ikke dette vært et problem, fordi kapasiteten har vært tilstrekkelig. Verden har en enorm fiberreserve fra dotcom-perioden på 1990-tallet. Hva skjer når den tar slutt?

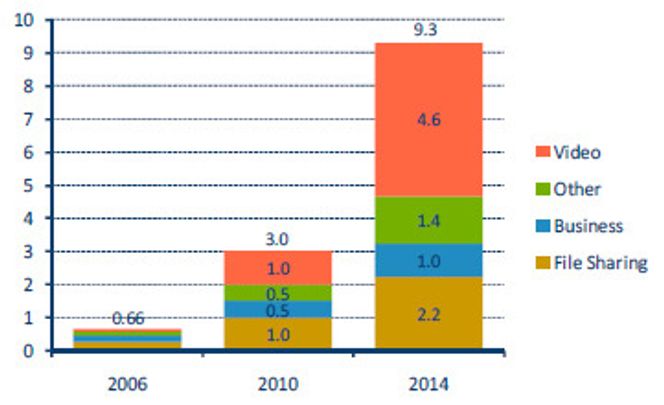

Enisa viser til gjeldende prognoser for veksten i nettrafikk, blant annet Cisco VNI («Visual Network Index»). Den viser at trafikken i 2014 vil være tre ganger så stor som i 2010. Videotrafikken vil nesten femdobles. Forretningstrafikken vil «bare» dobles, i likhet med den hittil dominerende fildelingstrafikken. Prognosen ser slik ut:

Slik Enisa ser det, er Internett en samling av 37.000 «autonome systemer» (AS), det vil si atskilte nett drevet av operatører og nettilbydere. AS-ene har et uoversiktlig kontaktnett seg imellom. 28.800 AS-er er forholdsvis små. 6.400 kan beskrives som mellomstore nettilbydere. 800 er store nettilbydere. 20 AS-er er «store transittilbydere». Eksempler er Abovenet, Cogent, Level 3, Global Crossing, Savvis, Sprint, Tinet og Verizon Business.

Transittilbyderne må hente sine inntekter gjennom avtaler med andre AS-er.

Det går ikke bra med dem. Hard konkurranse presser marginene ned mot null. Level 3, den største av dem, tapte 3,5 milliarder dollar i årene 2005 til 2009. Global Crossing, den nest største tapte 1,4 milliarder dollar i samme periode.

I andre bransjer fører slike tilstander til konsentrasjon. Det er en reell fare, ifølge Enisa, for at verden ender opp med en håndfull store transittilbydere. I så fall er det slutt på priskonkurransen. Skjer dette samtidig med at den eksisterende fiberkapasiteten er oppbrukt, kan det oppstå en situasjon der prisene mangedobles, og der noen mektige og uregulerte aktører kan holde en hel verden som gissel mens de venter på solid kompensasjon for å bygge ut kapasiteten.

En annen fare er at fellesfunksjonene som må ivaretas av de store transittilbyderne, neglisjeres fordi hver aktør mangler et økonomisk insentiv til å løse dem.

Resultatet kan følgelig bli at det store fellesskapet Internett faller for et kjent fenomen, «the tragedy of the commons».

Alle vil erkjenne behovet for utbygging av felles kapasitet og felles sikkerhet, men ingen, verken transittilbydere eller vanlige nettilbydere, ser noen mulighet til å tjene på egne investeringer i fellesskapet, og følgelig er det ingen som vil ta på seg å gjøre det som må til for å realisere felles beste.

Enisa beskriver dette slik:

«The central issue is that the security and resilience of the interconnection system is an externality as far as the networks that comprise it are concerned. It is not clear is that there is any incentive for network operators to put significant effort into considering the resilience of the interconnection system under extraordinary circumstances.»

Mye av det som skjer på Internett foregår i mørke.

Hvert AS har selvfølgelig grep over hva som skjer i eget nett, med sentral driftssenter, døgnkontinuerlig overvåking og så videre. Noe tilsvarende finnes ikke for Internett som helhet. AS-ene forstår sine egne nett, men har ikke innsyn i andres nett. Det er ingen innsikt noe sted over fysiske sammenknytningspunkter mellom AS-ene, eller mellom AS-ene og transittilbyderne. Ingen har kartlagt hvor trafikken faktisk går og hvordan belastningen fordeler seg.

Protokollen som fordeler trafikk mellom AS-ene har grunnleggende mangler.

Enisa beskriver implementeringene av Border Gateway Protocol (BGP) som «overraskende skjøre». Igjen: Ingen har spesielt å tjene på å gjøre dem robuste. Muligheten for feil er stor. I tillegg er sikkerheten svært mangelfull. Protokollen har ingen mekanisme for å sjekke av rutinginformasjonen som den fordeler er gyldig. Det fører til at feil eller sabotasje kan avspore trafikk. Trafikk på avveie kan avlyttes, filtreres eller sperres.

Enisa-rapporten viser blant annet til det kjente tilfellet fra april 2010 da Kina omdirigerte USA-trafikk på nettet på grunn av feil i rutingtabeller spredt av China Telecom, en av verdens store transittilbydere. Tilstanden varte i 18 minutter. En bevisst ondsinnet bruk av denne typen sårbarhet kan få nærmest uante følger.

Teknisk sett kunne BGP-problemet løses et stykke på vei gjennom en ordning kalt RPKI for «Resource Public Key Infrastructure» som også ville sikret en sjekk av rutinginformasjonen. Problemet er at RPKI er dyrt, og transittilbyderne har lite å tjene på å implementere den. Dessuten er RPKI teknologisk sett mangelfull, og det må investeres mer for å tette hull i den.

De siste fire år har AS-er fått følge av en ny type nettforvalter, primært rettet mot å levere spesifikt innhold.

Enisa kaller dem «Content Delivery Networks» (CDN). Blant de største er Google, Akamai og Limelight Networks. Nettverkene er forbrukervennlige fordi de overkommer en Internetts alvorligste strukturelle begrensninger, mangel på muligheter til å sikre at trafikken fra A til B velger den mest effektive ruten. Internett-protokollen er, som kjent, opptatt av at trafikken kommer fram, ikke at det skjer fort, og ikke at det skjer effektivt.

Framveksten av CDN har, ifølge Enisa, den effekten at mer trafikk gjøres mindre avhengig av transittjenester over store avstander. På den andre siden bærer CDN-ene nå så mye trafikk at sårbarheten øker. Skulle én svikte kan det være vanskelig å opprettholde Internettets tradisjonelle evne til å levere all trafikk.

Manglende økonomiske insentiver for aktører til å bidra til å løse fellesskapets problemer, muligheten for en utvikling der et fåtall store aktører kan endre de økonomiske betingelsene for nettilbyderne og deres kunder, og behovet for å utvikle bedre sentral teknologi, er momenter som ifølge Enisa taler for en viss offentlig regulering av Internett.

Dette er det selvfølgelig stor skepsis mot, selv om alle erkjenner at historisk sett er Internett en offentlig oppfinnelse: Det var opprinnelig et prosjekt finansiert av det amerikanske organet Darpa.

Enisa peker på at altfor ofte dreier «regulering» seg i praksis om sensur og overvåking. På den andre siden viser de, gjennom en sammenlikning av USA og Europa, at det i USA er en utvikling som kan føre til monopoler på nettaksess i et antall byer, mens mer subtil regulering i Europa for å sikre jevne konkurransevilkår har avverget en tilsvarende situasjon der.

Gjennom mange år har markedsmekanismer sikret både vekst og effektivitet, og denne situasjonen vil antakelig vare en stund til. Behovet for regulering er følgelig ikke akutt. Men behovet kan oppstå plutselig. Ifølge Enisa vil EU være tjent med å ha tenkt gjennom mulige framtidige situasjoner på forhånd, og ha forslag klare. Alternativet er å bli tatt på senga, med de farene det medfører for kortsiktige, ugjennomtenkte og til og med panikkartede vedtak.

Det viktigste, ifølge Enisa, er at ledere (politikere) straks begynner å anstrenge seg for å oppnå innsikt i hvordan Internett henger sammen. I dag har ingen oversikt. Forstår man ikke et fenomen, vil forsøk på å regulere det uvegerlig forverre situasjonen.

Det foreslås fire sett med tiltak fra det offentlige:

1. For å få bedre innsikt: Støtte konsistente og grundige granskning av alle store tilfeller av nedetid og trafikkproblemer. Publisere disse granskningene. Støtte langsiktig måling av trafikk og ytelse i nettet.

2. For å få bedre teknologi: Finansiere forskning i nøkkelområder som distribuert snokvarsling og nye sikkerhetsmekanismer.

3. For å få nettilbyderne til å trekke i lag: Avdekke og fremme god praksis, oppmuntre til brede tjenestetilbud og fremme testing av utstyr.

4. For å bygge tillit mellom private og det offentlige: Opprette mange partnerskap mellom privat og offentlig sektor rundt problemstillinger som feiltoleranse og robuste nett.

Disse fire tiltakspakkene vil danne et grunnlag for felles problemforståelse mellom det private og det offentlige, skriver Enisa. Felles problemforståelse er et grunnleggende vilkår for hensiktsmessig regulering: Den skal, som kjent, bidra til å fremme, ikke hemme, fellesskapet.