Kunstig intelligens er ikke lenger forbeholdt forskere og science fiction. Mange av oss forholder oss til det daglig, kanskje uten å tenke over det. Digitale assistenter som Siri, Google Now og Cortana er for mange dagligdagse eksempler på tjenester som bruker maskinlæring og kunstig intelligens til å gi oss den informasjonen vi trenger der og da, ofte ved hjelp av talegjenkjenning.

Færre feil enn hos mennesker: Satte rekord i bildegjenkjenning

Bildekategorisering

Et annet, relatert område hvor kunstig intelligens gjør seg gjeldende, er innen bildegjenkjenning. Bruk av nevrale nettverk har relativt nylig først til betydelige framskritt innen særlig klassifisering av bilder.

Nevrale nettverk er kunstige etterligninger av nervevev fra biologiske hjerner. Evnen til å lære ved hjelp av trening er sentral for slike løsninger.

Google kom denne uken med en introduksjon til hvordan selskapet jobber for å forstå hvordan nevrale nettverk gjenkjenne objekter i bilder. I et blogginnlegg skriver en gruppe forskere ved selskapet at selv om nevrale nettverk er nyttige verktøy basert på velkjente, matematiske metoder, så er det mye man ikke forstår om hvorfor visse modeller fungerer mens andre ikke gjør det.

Facebook: Åpner opp verktøy for maskinlæring

Lagdelt

– Vi trener et kunstig, nevralt nettverk ved å vise det millioner av treningseksempler, samtidig som at vi gradvis justerer nettverksparameterne inntil det gir oss de klassifiseringene vi ønsker. Nettverket består typisk av 10 til 30 stablede lag med kunstige nevroner, skriver Google-forskerne.

Bildene mates inn i et input-lag, som kommuniserer med laget over, og så videre, inntil man får «svaret» ut av det siste laget.

– Blant utfordringene med nevrale nettverk er å forstå nøyaktig hva som foregår i hvert lag. Vi vet at etter trening, vil hvert lag progressivt trekke ut egenskaper med stadig høyere nivå fra bildet, inntil det siste laget i praksis tar en avgjørelse om hva bildet viser, skriver forskerne.

– De avsluttende lagene setter sammen dette til fullstendige tolkninger. Disse nevronene aktiverer som en respons på veldig komplekse ting som hele bygninger eller trær.

Les også: Skal bruke Watson i personlighetstester

Genererer bilder

En måte å vise hva som egentlig foregår, er å snu hele løsningen opp-ned, slik man ber nettverket om å forbedre et bilde en måte som fremkaller en bestemt tolkning – for eksempel objektene brukerne ser etter. Derfra er veien kort til at nettverket også kan generere bilder, nærmest ut fra dets egen fantasi, fra bilder som kanskje ikke inneholder annet enn vilkårlig støy.

Men dette er ingen feilfri metode, og i noen tilfeller leter nettverket etter noe annet enn det man i utgangspunktet skulle tro, fordi det ikke korrekt har lært seg hvordan objektet man leter etter, faktisk ser ut.

I et eksempel som nevnes, ble et nevralt nettverk bedt om å vise bilder av hantler. Det var riktignok hantler på bildene som systemet presenterte, men alle bildene viste også en vektløfter som løftet på dem.

– Kanskje nettverket aldri har blitt vist hantler uten en arm som holdt i dem. Visualisering kan hjelpe oss med å korrigere disse treningsfeilene, skriver forskerne.

Farlig? Bill Gates uroet over kunstig intelligens

Overtolkning

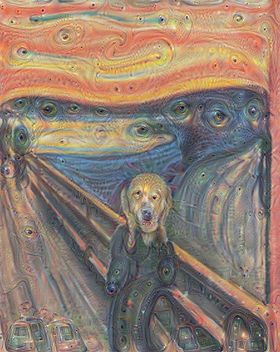

En annen metode som kan benyttes, er at la nettverket avgjøre selv hva som skal forsterkes, i stedet for å fortelle det nøyaktig hva man ønsker. Man lar nettverket ta utgangspunkt i et gitt lag og ber det forsterke hva enn det måtte ha oppdaget.

Spesielt dersom man velger høynivå-lagene, hvor mer komplekse egenskaper i bildene kan identifiseres, vil nettverket kunne overtolke bildet.

– Når vi forteller nettverket, «Uansett hva du ser der, ønsker vi mer av det!», skaper dette en feedback-løkke. Dersom en sky ser litt ut som en fugl, vil nettverket få det til å se ut som en fugl. Dette vil igjen få nettverket til å gjenkjenne fuglen ende sterkere i neste runde, og så videre, inntil en høyst detaljert fugl dukker opp, tilsynelatende ut av ingenting.

Selv relativt enkle, nevrale nettverk kan ifølge Google-forskerne overtolke et bilde, omtrent som barn (eller voksne) som ser på skyer og forsøker å gjenkjenne objekter i de egentlig vilkårlige formene.

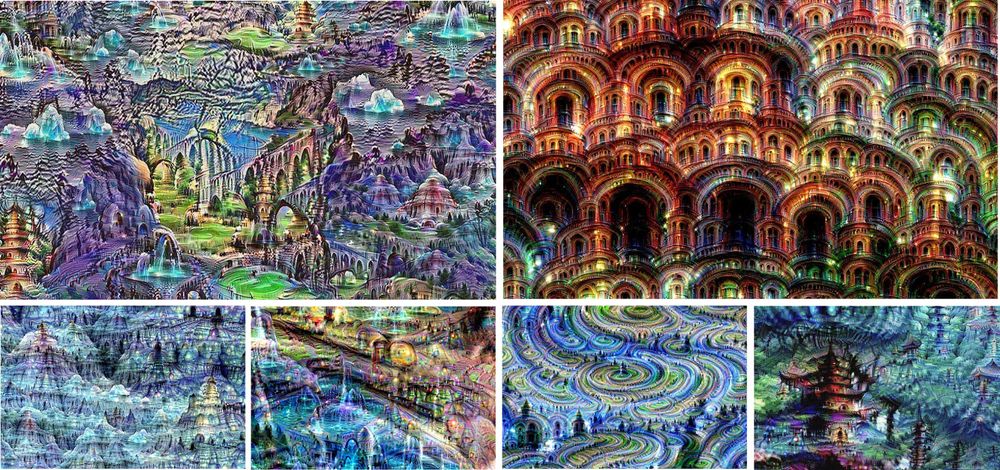

Det er ikke bare på bilder av skyer slike teknikker kan brukes. Men ifølge forskerne varierer resultatene en del, avhengig av type bilde man bruker. Dette skyldes at egenskapene i bildet leder nettverket i retning av visse tolkninger.

For eksempel vil horisontale linjer ofte bli fylt med tårn og pagoder, steiner og trær blir til bygninger, mens bilder av løv ofte blir tolket som fugler eller insekter.

Google: Øker satsingen på kunstig intelligens

Kunst?

Men det er som nevnt også mulig å gi nettverket bilder kun bestående av virkårlig støy. Illustrasjonen øverst i saken gjengir eksempler på hva dette kan resultere i.

– Teknikkene som presenteres her, hjelper oss med å forstå og visualisere hvordan nevrale nettverk er i stand til å utføre vanskelige klassifiseringsoppgaver, å forbedre nettverksarkitektur og å sjekke hva nettverket har lært under treningen. Det får oss også til å undres om nevrale nettverk vil bli et verktøy for kunstnere – en ny måte å blande visuelle konsepter på – eller kanskje kaste litt lys over røttene til den kreative prosessen generelt, skriver forskerne.

Flere bilder generert av nevrale nettverk finnes på denne siden.

Bedre bildesøk: Program beskriver bilder med ord