Datamaskiner har til nå sjelden vært særlig mottakelige for menneskers følelser, men det kan raskt endre seg, noe flere forskningsgrupper – tilsynelatende uavhengig av hverandre, har presentert de siste ukene.

Den aller mest konkrete av disse nyhetene handler om et nytt, webbasert verktøy fra Microsofts Project Oxford.

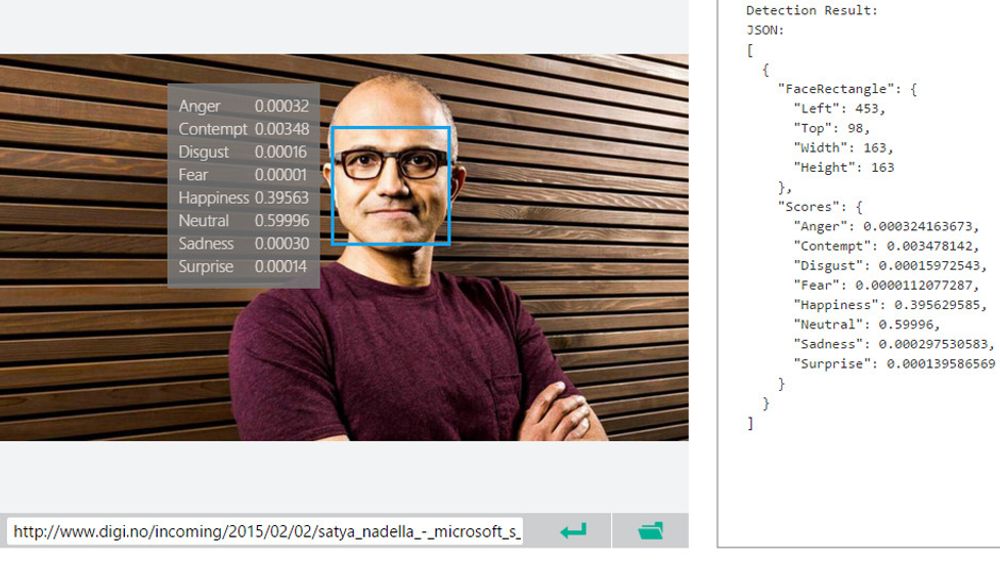

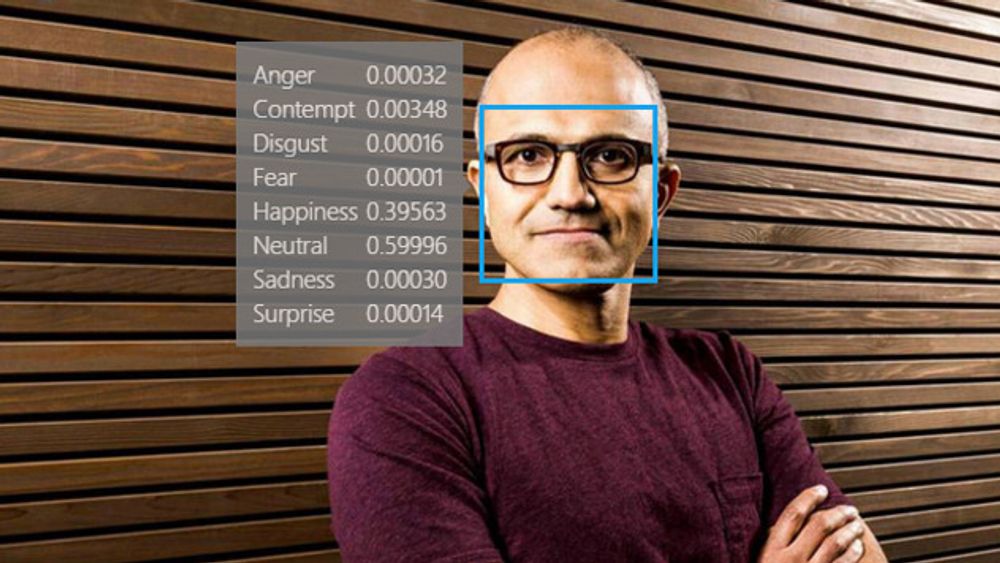

I dette verktøyet kan man lenke til eller laste opp bilder av ansikter, hvorpå verktøyet forsøker å tolke hvor stor andel av ansiktsuttrykket som uttrykker åtte grunnleggende tilstander – sinne, forakt, frykt, avsky, glede, nøytralitet, tristhet eller overraskelse.

Eksempelet Satya

I bildet øverst i saken, hvor vi har testet med et pressebilde av Microsoft-sjef Satya Nadella, fortelles det at uttrykket hans er temmelig nøytralt (ca. 60 prosent), men har også en betydelig del av glede i seg. Hver av de øvrige følelsene utgjør under en promille, bortsett fra forakt som ligger på 3,5 promille.

Ansiktsuttrykk spiller en viktig rolle i vår naturlige kommunikasjon med andre mennesker. Derfor er det kanskje ikke unaturlig at ansiktsuttrykk etter hvert også blir en del av vår kommunikasjon med datamaskiner.

I et kort blogginnlegg hvor Microsoft beskriver den nye tjenesten, som også tilbys som et programmeringsgrensesnitt for utviklere, skriver selskapet at verktøyet for eksempel kan brukes i systemer hvor markedsførere kan måle hvordan folk reagerer på for eksempel en utstilling i en butikk, en film eller mat de får servert.

Åpner koden: Google gjør maskinlæring tilgjengelig for alle

Mikrouttrykk

Men det stopper ikke nødvendigvis der. En gruppe forskere som alle er tilknyttet IEEE, har utviklet algoritmer som er i stand til å registrere en type ufrivillige ansiktsbevegelser som kalles for mikrouttrykk. Disse kan avsløre følelser som mennesker egentlig ønsker å skjule.

Fordi disse mikrouttrykkene er svært korte og lite intense, er de vanskelige å registrere for andre mennesker. Men ved hjelp av høyhastighetskameraer og ny programvare, kan de snart bli vanskeligere å holde skjult.

Det er dog ingen enkel prosess. For det første må man kunne gjenkjenne hvilke endringer i ansiktet som karakteriserer et mikrouttrykk. Deretter må man finne ut hvilke følelser et slikt uttrykk faktisk gjengir. Det krever en database over slike uttrykk. Dette var det første forskerne skapte.

Dernest måtte de ta i bruk en algoritme som kunne «forstørre» mikrouttrykkene slik at de identifiseres. Men selve oppdagelsen av mikrouttrykkene må gjøres uten bruk av denne algoritmen, siden den forstørrer alle bevegelser, ikke bare små ansiktsuttrykk.

Til slutt klassifiseres uttrykkene som i tre kategorier, positivt, negativt eller overraskelse, noe programvare gjenkjenner etter å ha blitt trent opp med eksempler fra databasen.

Forskerne mener at dette vil kunne være spesielt nyttig i forbindelse med rettsvitenskap og psykoterapi.

Forskningen omtalt av MIT Technology Review og i forskernes egen, vitenskapelige artikkel.

Tekstanalyse: Nå kan Watson «forstå» hva du mener

Følsom tale

Men det er ikke bare ansiktsuttrykkene som kan avsløre hva vi føler. Følelser uttrykkes ofte i like stor grad via stemmen. Også på dette området ser det nå ut til at datamaskiner kan bli flinkere til å tolke hva mennesker føler enn det andre mennesker greier.

New Scientist omtalte i forrige uke en nye programvare som har blitt utviklet av forskere ved University of Rochester i New York.

Av en samling på 700 lydspor, greide systemet å tolke personens emosjonelle tilstand riktig i 72 prosent av tilfellene. I en test blant innleide personer som lyttet til ti lydspor hver, var suksessraten bare på 50 prosent.

Men programvaren til forskerne var også dyktigere enn menneskene til å avgjøre hvilke lydspor som ikke kunne klassifiseres nøyaktig. Dersom man utelot disse lydsporene, økte suksessraten til 85 prosent.

Forskningsartikkelen om denne programvaren er tilgjengelig her.

Leste du denne? Kan vi føle omsorg for maskiner?