Muligheten til å depikselere et bilde - eller forstørre et bilde langt over den opprinnelige oppløsningen - brukes ofte i alle slags detektivserier.

I den virkelige verden er det ikke mulig å lage informasjon ut av ingenting. Men nylig kom forskere fra Duke University på noe som minner om denne teknologien.

Løsningen kalles Pulse - en algoritme som genererer livaktige bilder med høy oppløsning fra uskarpe og pikselerte bilder. I en forhåndspublisert forskningsartikkel som beskriver systemet, demonstrerer forskerteamet Pulse med portrettbilder.

I stedet for å ta et pikselert portrett og legge til detaljer, fungerer Pulse ved å generere bilder med høy oppløsning som ligner det originale bildet hvis oppløsningen skaleres ned. Alt dette gjøres av seg selv, så det er ikke nødvendig å trene på like bilder med lav og høy oppløsning.

Pulse gjenskaper selvfølgelig ikke ansiktene til de opprinnelige personene, fordi nødvendig informasjon mangler. Som forskerne selv skriver:

«Mange høyoppløselige bilder kan tilsvare nøyaktig samme lavoppløsningsbilde».

Virkelighetens CSI må derfor fortsette å lide av dårlige overvåkningsbilder. På den annen side mener forskerne at metoden har potensial på mange datatyper, der det er vanskelig å få tak i bilder med høy oppløsning, for eksempel innen astronomi og satellittdata.

.jpg)

Høyt profilert AI-forsker hos Google: – Jeg har fått sparken

Gjør alle hvite

Så langt, så bra.

Problemet oppstod da et Github-prosjekt basert på Pulse-koden ble testet på ikke-hvite mennesker denne uken. Her viste algoritmen en klar tendens til å gjenskape alle ansikter – uavhengig av original etnisitet – som hvite personer.

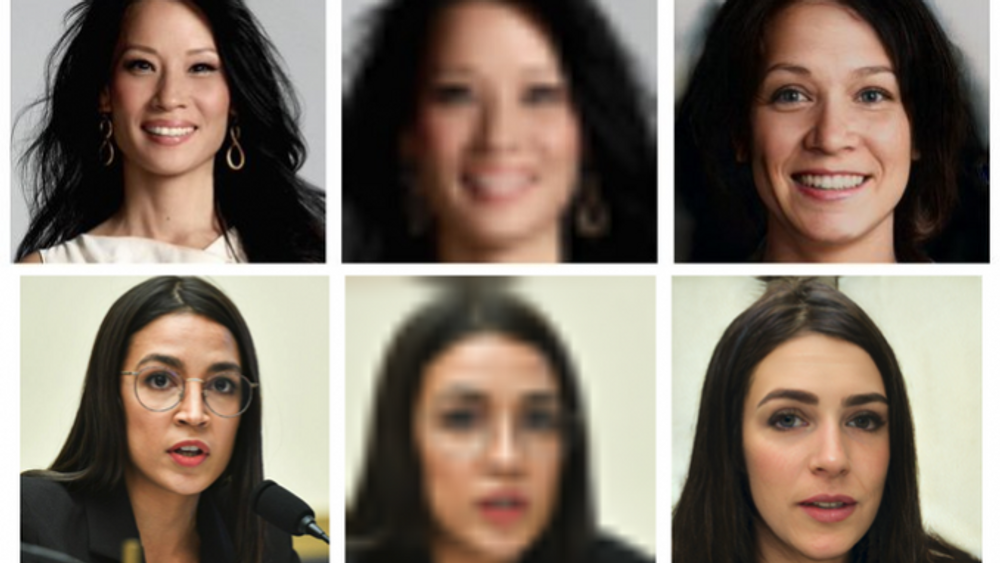

Robert Osazuwa Ness, ML-forsker ved Gemalon, demonstrerer her hvordan koden responderer på henholdsvis det amerikanske kongressmedlemmet Alexandria Ocasio-Cortez og skuespillerinnen Lucy Liu.

– Jeg vil ikke gjøre narr av de akademiske bidragene til disse forfatterne, skriver Robert Osazuwa Ness om resultatet.

– Men hvis dype generative modeller skal være nyttige, må vi forstå begrensningene og de sosiale implikasjonene, understreker han.

Dype skalaer

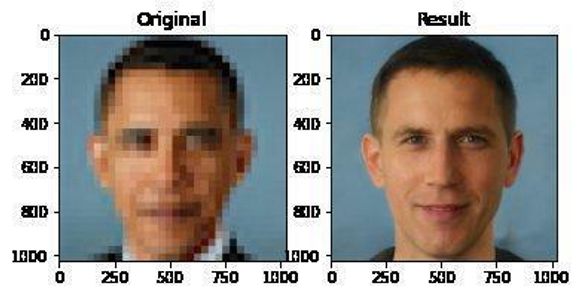

Et bilde av en pikselert Barack Obama, transformert av Pulse til en hvit mann, gikk raskt viralt i et AI-miljø som allerede er godt i gang med selvransakelse av mangel på mangfold, rasemessig skjevhet og hvordan programvare for eksempelvis ansiktsgjenkjenning brukes til undertrykkelse.

Imidlertid blir de dype splittelsene i AI-feltet virkelig tydelige når Facebooks AI-sjef og mottaker av Türing-prisen, Yann LeCun, twitrer på søndag at maskinlæringssystemer har en skjevhet når data har skjevhet.

– Dette ansiktsoppsamlingssystemet gjør at alle ser hvite ut fordi nettverket var forhåndsutformet på FlickFaceHQ, som hovedsakelig inneholder bilder fra hvite mennesker. Tren det samme systemet på et datasett fra Senegal, så vil alle se afrikanske ut, skriver han.

Den tolkningen falt mange tungt for brystet. Ikke fordi uttalelsen i seg selv er feil, men fordi den lett fremstår som en forenkling eller bagatellisering av problemets omfang.

Datalog Timnit Gebru, grunnlegger av Black in AI og en av to tekniske leads i Googles etikk i kunstig intelligens-team, uttrykte frustrasjon:

– Jeg er lei av dette. Lei av det, skriver hun om Yann LeCuns forklaring.

– Mange lærde har prøvd å forklare. Hør på oss. Du kan ikke bare redusere skader forårsaket av maskinlæringen til datasettforskjeller.

Open AIs nye modell: Knuste andre i ekstremt krevende test

Som kampen for NN

Gebru fikk støtte fra blant andre Nicolas Le Roux, som er Google Brain-forsker og styreleder for CIFAR-konferansen. Han skriver at han har lært mye av Yann LeCun, som til og med var med på å evaluere Le Roux sin doktorgrad.

– Hans konstante avvisning av skadene som direkte eller indirekte forårsakes av maskinlæringsmiljøet er svært problematisk, sier Le Roux.

Han sammenligner situasjonen med LeCuns eget pionerarbeid på 1990-tallet med å få feltet til å forstå at nevrale nettverk var veien videre for AI.

– Det er dette som skjer her, men det er ingen ImageNet som overbeviser deg om å forandre mening.

Oppgjør

Mandag prøvde Yan LeCun å forklare sin stilling ved å forklare at data bare er én kilde til skjevhet. I en lengre tråd forklarer han de forskjellige tekniske kildene til problemet.

Men splittelsen vedvarer.

For Timnit Gebru og likesinnede synes LeCuns fokus på det tekniske eller matematiske problemet å overse de omkringliggende problemstillingene – for eksempel at de representative dataene ikke blir samlet inn, at forskning blir publisert uten å bli sjekket for denne typen skjevheter, og at det kontinuerlig blir de samme gruppene som trekker det korteste strået; kvinner og minoriteter.

Med de utfordringene som finnes i flere AI-systemer, er det behov for at personer med en posisjon som Yann LeCun skal anerkjenne problemet. Som Google AI-forsker Charles Sutton uttrykker det:

– Hvis det hender at de fleste/mange AI-systemer brukes til å sementere ulikhet, er det et oppgjør med forskningsfeltet som er berettiget. Dette er grunnen til at alle AI-teknologer trenger å tenke og handle for å motvirke dette.

Denne artikkelen ble først publisert på Ingeniøren.

Metas KI-tjeneste kommer i Europa