Fremveksten av tingenes Internett (IoT), 5G og kunstig intelligens (AI) vil bety en enorm vekst i datamengdene som skal overføres over nettet. For eksempel vil utstrakt bruk av IoT resultere i at store datamengder skal overføres fra IoT-enheter til skyen for behandling, noe som vil bety forsinkelser og stor belastning på nettet.

Nå har standardiseringsorganisasjonen IEEE definert en ny standard – IEEE 1934 – for hvordan ressurser skal distribueres mellom skyen og IoT-enheter/sensorer i kanten av nettverket. Standarden er basert på arbeid som er gjort av det såkalte Openfog Consortium, som består av selskaper som Cisco, Dell, Intel, ARM, Microsoft og Princeton University. Det skriver Network World.

Datatransport tar tid

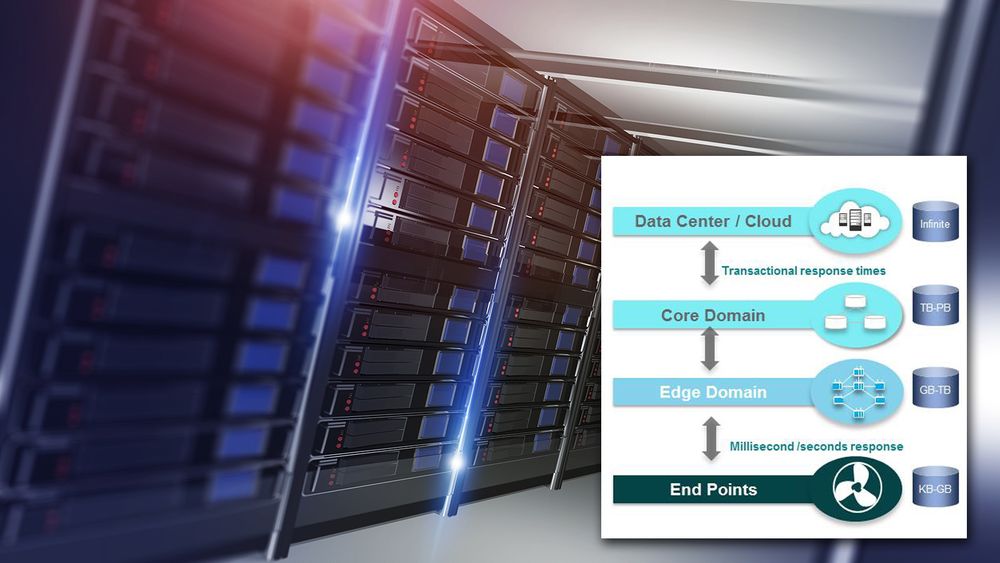

I en pressemelding definerer Openfog Consortium «fog computing» som en horisontal arkitektur på systemnivå som distribuerer ressurser og tjenester for dataprosessering (computing), lagring, kontroll og nettverk på veien fra nettskyen til IoT-enhetene. Det skal gjøre det mulig å legge tjenester og applikasjoner nærmere der hvor dataene produseres.

– Vi har nå en plan, som vil få fart på utviklingen av nye applikasjoner og forretningsmodeller som muliggjøres gjennom fog computing, sier Helder Antunes, styreformann i Openfog Consortium og direktør i Cisco, i en pressemelding.

Noe av bakgrunnen for behovet for å legge databehandling nærmere brukerne, er de fysiske begrensningene i fiberkablene. For 5G er visjonen at svartider skal være ned mot eller under ett millisekund.

I fiberoptikken går dataene med en hastighet på rundt 200 kilometer per millisekund. Det betyr at en spørring og et svar som skal unnagjøres på ett millisekund, ikke kan være mer enn 100 kilometer unna. Og da ser vi bort fra prosesseringstid i serverne – og det kan vi selvsagt ikke gjøre. Ergo må dataene befinne seg enda nærmere brukeren. Det betyr at særlig mobilnett, men også fastnett, må ha en stadig mer distribuert datasenter-arkitektur. Det kan åpne for nye aktører i enkelte markeder, for det er ikke gitt at det er mobiloperatørene som skal bygge og drifte denne desentraliserte datasenterstrukturen.

Standarden vil få fart på produktutviklingen

Fog computing er noe Cisco har snakket en del om de siste årene, og tanken er at man ved å plassere mer datakraft i ytterkanten av nettverket – nær IoT-enhetene – kan behandle de mest tidssensitive dataene der i stedet for å sende store datamengder opp i skyen.

– Med de enorme datamengdene disse enhetene og sensorene vil generere etter hvert, blir det ikke mulig eller hensiktsmessig å analysere alt i skyen. Vi må gjøre det nærmere enhetene. Det vil være dumt å laste opp all trafikk og informasjon som vil bli skapt i tingenes internett, uttalte Ciscos tidligere teknologidirektør Nils Ove Gamlem til digi.no for en tid tilbake.

Openfog Consortium skriver at de er fornøyd med at arbeidet de har gjort har blitt brukt som grunnlag for en IEEE-standard.

– IEEE-standarder danner byggesteinene innenfor produktutvikling, ved å etablere konsistente protokoller som kan forstås og tas i bruk av alle. Dette bidrar til kompatibilitet og interoperabilitet og forenkler produktutvikling, samt gjør det lettere å få produktene raskt ut på markedet, skriver organisasjonen.

Les også vår innsiktsartikkel om fog computing: Når ikke alt kan gjøres i skyen – dette er «fog computing» og «edge computing» (Ekstra)