En feilkonfigurert regel i en brannmur endte tirsdag med å ta ned millioner av nettsteder over hele verden da driftsleverandøren Cloudflare gikk ned for telling. Det skriver selskapet i en oppdatering på egne hjemmesider.

– Vi skjønner at denne typen hendelser er svært smertefulle for kundene. Våre testrutiner har ikke vært gode nok, og vi vurderer nå test- og produksjonsrutinene våre for å sørge for at dette aldri skal skje igjen, skriver teknologisjef John Graham-Cumming i Cloudflare.

Millioner av nettsteder

Selskapet tilbyr skytjenester til millioner av nettsteder, og fungerer som et leveransenettverk og domenenavnstjener.

Tjenestene selskapet leverer skal beskytte mot overbelastning av infrastruktur, spam- og DDoS-angrep.

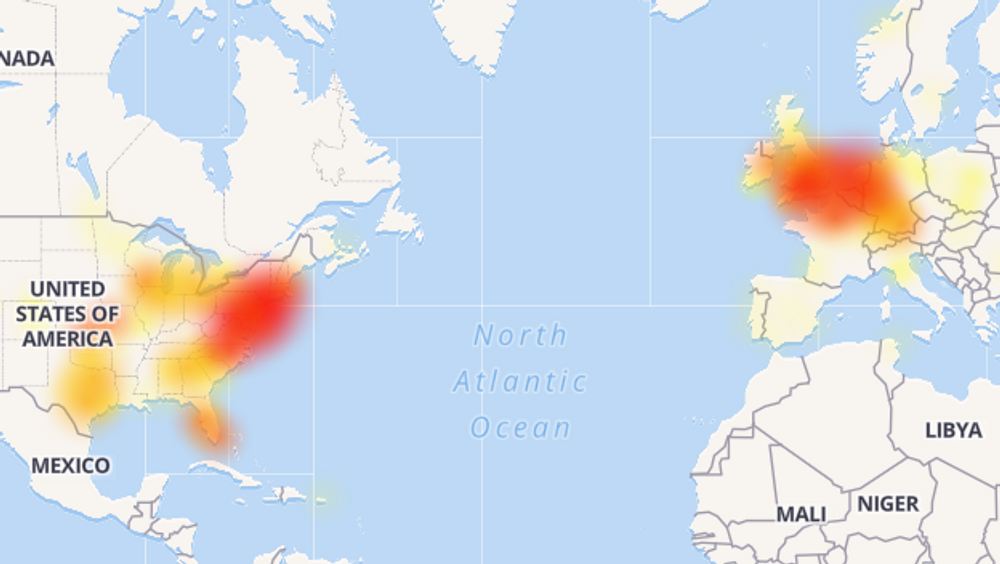

Nettbrukere over hele verden opplevde å få «502»-feilmeldinger da de kjørte spørringer mot hjemmesider som får levert tjenester fra Cloudflare. Også norske nettsteder ble rammet av problemene.

Nedetiden varte i rundt 30 minutter. Da det stod på som verst så selskapet et massivt hopp i prosessorbruk. Det sørget for at primære og sekundære systemer falt ned i datasentre over hele verden.

«Regular expression»-feil

Senere undersøkelser skulle vise at det var en miskonfigurert regel i en rutineoppgradering av brannmurene som sørget for den massive overbelastningen av infrastrukturen. Hensikten til den nye regelen var å blokkere enkelte JavaScript-angrep.

Regelen ble først sluppet i et testmiljø, men feilen ble ikke oppdaget der.

Oslomet gikk i full krisemodus da alle IT-systemene gikk ned for telling

Videre undersøkelser viste at en av de nye brannmurreglene inneholdt en «regular expression»-feil.

Programmeringsverktøyet brukes til å søke etter mønstre, og er praktisk å bruke når man vil identifisere for eksempel skummel trafikk i en brannmur.

Serverclustre over hele verden brukte plutselig 100 prosent av tilgjengelig CPU-kraft da feilen i koden nådde produksjonsmiljøene.

Trafikken droppet 80 prosent

På det verste droppet trafikken med over 80 prosent. Dette er første gang selskapet skal ha hatt lignende problemer.

– Vi slipper oppdateringer til produksjonsmiljøene hele tiden, og har automatiserte systemer som kjører tester for å forhindre at denne typen hendelser skjer.

– Uheldigvis ble disse brannmurreglene sluppet, og det førte til global nedetid, oppsummerer teknologisjef John Graham-Cumming i Claudflare i oppdateringen.

Da feilen i brannmuren ble oppdaget kjørte Cloudflare en tilbakestilling av regelsettet.

Dette sørget for at CPU-bruk falt tilbake til normal. Etter ny konfigurasjon og flere tester ble regelsettet igjen sluppet ut i produksjonsmiljøet.

Da fungerte serverene som de skulle.