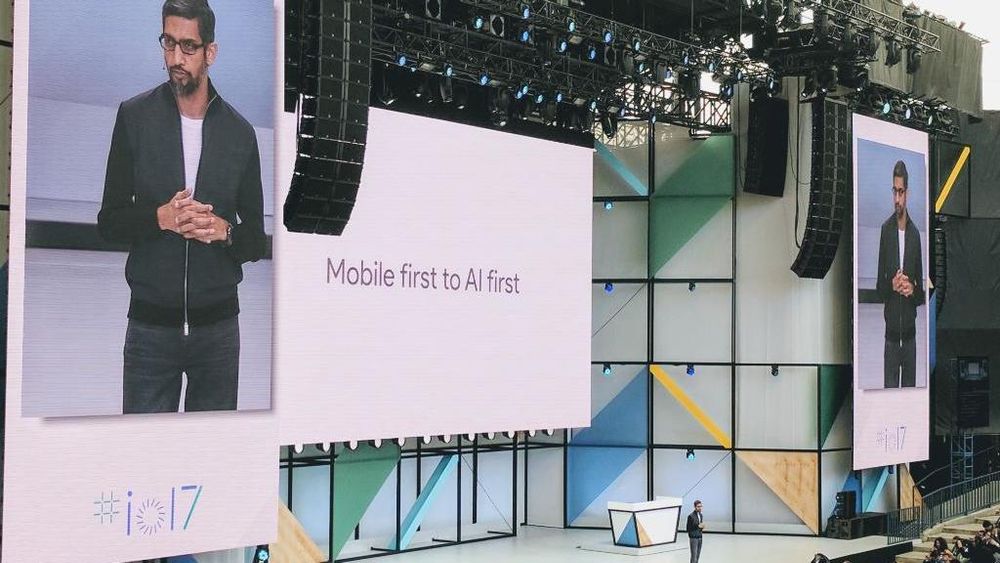

Den årlige utviklerkonferansen til Google, Google I/O åpnet i går med en hovedtale hvor hovedbudskapet fra Google-sjef Sundar Pichai var at vi nå er inne i et skifte fra en periode hvor «mobile first» har vært det sentrale, og over til «AI first» (Artificial Intelligence – kunstig intelligens). Det er på dette området at det vil skapes helt nye muligheter i årene som kommer.

Google har de siste årene tatt i bruk kunstig intelligens for å forbedre en del av selskapets produkter, men nå revurderer selskapet alle produktene for å se på hvilke områder kunstig intelligens kan gjøre dem bedre.

Google Lens

Frontfigur for mye av dette vil være Google Assistant, som i Norge stort sett bare er tilgjengelig gjennom meldingsappen Google Allo, og kun på engelsk. Støtte for flere språk skal komme i løpet av året, men ikke norsk.

Mer spennende er nok derfor Google Lens, et nytt initiativ som handler om «computer vision», datamaskiners evne til å se og gjenkjenne objekter.

Med Lens-støtte i Assistant vil den digitale assistenten gjenkjenne det brukeren ser på (via mobilkameraet eller bilder på skjermen) og kunne utføre oppgaver basert på dette – for eksempel fortelle hva slags blomst man ser, fortelle om åpningstidene eller menyen til restauranten brukeren ser logoen til, eller å lese innloggingsdataene til et WiFi-nettverk fra et klistremerke og så koble enheten til dette nettverket uten annet enn en siste godkjennelse fra brukeren. Se bildet over.

Leste du denne? «Intelligent» assistent prøvde å bestille dukkehus etter å ha overhørt samtale på tv-en

Første bruksområde

Det første stedet Google Lens vil bli tilgjengelig for brukerne, er i Google Photos. Her vil teknologien brukes til å gjenkjenne objekter. Ikke generelle objekter som hus, bil og maleri. Programvaren skal for eksempel kunne fortelle brukeren hvilken bygning eller hvilket maleri som er avbildet. Dette skal komme senere i år.

Et annet område der Google Lens vil være involvert, er i videreutviklingen av Project Tango, Google AR-teknologi (Augmented Reality) som nå skal kombineres med Google Maps for å skape det Google kaller for VPS – Visual Positioning Service, en tjeneste som utnytter visuelle detaljer i nærheten, spesielt innendørs, for å hjelpe brukeren med å finne fram – for eksempel til en gitt vare i en butikkhylle. Systemet skal ha centimeternøyaktighet.

Kombinert med tale skal dette også kunne være til stor hjelp for blinde.

Les også: Google splitter Android i to

Nye spesialprosessorer

For å drive alt dette har Google utviklet en ny generasjon av selskapet Tensor Processing Units (TPU), prosesseringsenheter spesielt beregnet for å trene og kjøre maskinlæringsmodeller på en effektiv måte. I den nye generasjonen har det blant annet blitt fjernet en del flaskehalser. Dette skal ha bidratt til å øke den generelle ytelsen.

Som eksempel forteller Google at et system med åtte slike TPU-er i løpet av en ettermiddag kan trenes med samme nøyaktighet som det et system med 32 av de beste GPU-ene på markedet bruker en hel dag på.

Hver TPU har en flyttallsytelse på 180 teraflops. De vil typisk settes samme i det Google kaller for «TPU pods», som består av 64 TPU-er og kan levere en flyttallsytelse på opptil 11,5 petaflops.

Nytt er det også at Google skal tilby tilgang slike TPU-er som en del av Google Cloud Platform, i første omgang som en alfatjeneste.

Google: «Skynet» er mange tiår unna

Maskinlæring i mobilen

Google skal også komme med det som har fått navnet TensorFlow Lite. TensorFlow er Googles åpen kildekodebaserte programvarebibliotek for maskinlæring. Lite-versjonen er ment å kjøres direkte på Android-enheter. Dette skal komme som et tillegg til Android O-utgaven senere i år og skal gi enhetene lokal maskinlæringskapasitet, noe som skal gjøre dem mindre avhengige av nettskyen.

Noe av den nye funksjonaliteten i Android O skal fra starten av benytte slike lokale maskinlæringsegenskaper. Dette gjelder blant annet den nye og smartere funksjonen for å markere og kopiere tekst.

Men med TensorFlow Lite skal også app-utviklere kunne tilby funksjonalitet basert på maskinlæring og teknikker som LSTM (Long short-term memory). Dette skal kombineres med en nytt Android-rammeverk for maskinvareakselerasjon av nevrale beregninger.

Det skal i Android tilbys et nytt Neural Network API som skal gi TensorFlow Lite tilgang til brikkespesifikke akseleratorer. Ifølge Android-teknologisjef Dave Burke regner Google med at det etter hvert vil komme digitale signalprosessorer spesielt designet for trening og inferens av nevrale nettverk.