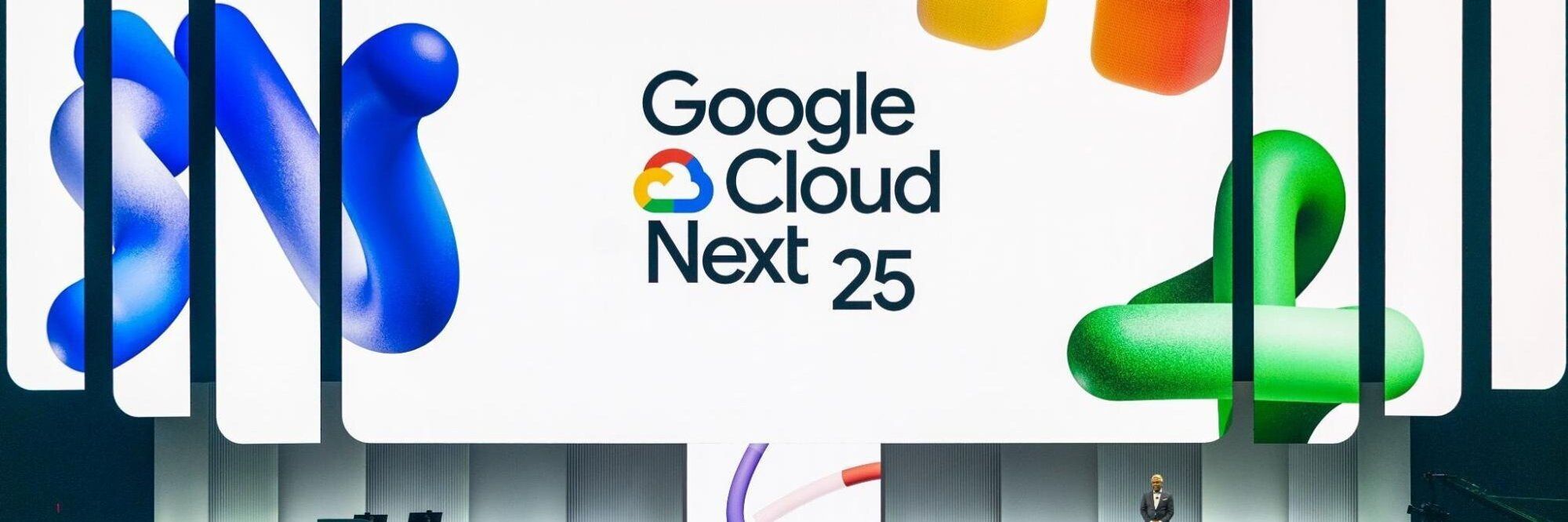

Årets utgave av utviklerkonferansen Google I/O startet i Mountain View, California, tirsdag kveld norsk tid. Men den første hovedtalen handlet lite om nye utviklerverktøy eller programmeringsgrensesnitt. I stedet fortalte Googles representanter om all den nye funksjonaliteten som selskapet kommer til å tilby i mange eksisterende produkter i nær framtid.

Felles for det aller meste er at det er gjort mulig ved hjelp av framskritt innen kunstig intelligens og maskinlæring.

Assistant

Ikke overraskende fikk Google Assistant mye oppmerksomhet. Den digitale assistenten, som skal bli tilgjengelig på norsk i løpet av relativt kort tid, skal blant annet bli mye flinkere til å snakke. Ikke bare selve ordene, men med entstørre register av rytme og pauser, slik at det i større grad lyder slik mennesker snakker. Teknologien kalles for Wavenet og skal gjøres tilgjengelig senere i år.

Ifølge Google-sjef Sundar Pichai skal assistenten, i alle fall på engelsk, kunne snakke med stemmen til seks nye personer. Men målet er å kunne få assistenten til å snakke med alle mulige aksenter og dialekter. Dette ligger nok likevel et godt stykke fram i tid.

Assistenten, som skal være installert på mer enn en halv milliard enheter, skal dessuten kunne snakke mer naturlig. Blant annet skal den endelig håndtere kontinuerlige samtaler, uten at brukeren stadig må si «Hey Google» når hun bestemmer seg for å komme med oppfølgingsspørsmål.

Det skal også være mulig å stille flere spørsmål i samme setning.

Støtten for slike kontinuerlige samtaler skal rulles ut i løpet av de nærmeste ukene.

Oppmuntres til å være høflige

En bekymring hos en del foreldre er at barna deres blir veldig kommanderende og lite høflige når de hele tiden kan fortelle en digital assistent hva den skal gjøre. Derfor skal Google Assistant utstyres med en valgfri funksjon som kalles for Pretty Please, som gjør at assistenten responderer ekstra mye på høflighet.

Google har inngått partnerskap med en rekke takeaway-kjeder som skal gjøre det enkelt å bestille mat og drikke ved hjelp av Google Assistant, som for øvrig også skal bli en del av Google Maps i løpet av sommeren. Bestillingsmulighetene kommer sannsynligvis først noe senere, men i år.

Ringer frisøren

Men langt fra alle butikker og tjenesteleverandører har en digital tilstedeværelse, enten gjennom apper eller websider. For å bestille time hos den lokale frisøren, må du kanskje ringe. Eventuelt kan Google Assistant gjøre dette for deg.

Google demonstrerte flere virkelige samtaler mellom Google Assistant hvor assistenten ringte opp en frisør eller en restaurant for å bestille time eller reservere bord. Ifølge Pichai har Google jobbet i en årrekke med å forbedre teknologiens forståelse av naturlige språk.

(artikkelen fortsetter under)

Duplex

Resultatet av dette er en teknologi som Google kaller for Duplex. Den er nærmere beskrevet i dette blogginnlegget. Også opptak fra et par av disse samtalene er tilgjengelige der.

Mennesker snakker ofte litt usammenhengende, starter setninger på nytt, korrigerer seg selv og skyter inn mer informasjon på nokså vilkårlige steder i samtalen. Også dette skal Duplex kunne håndtere, for eksempel en setning som dette.

«So umm Tuesday through Thursday we are open 11 to 2, and then reopen 4 to 9, and then Friday, Saturday, Sunday we... or Friday, Saturday we're open 11 to 9 and then Sunday we're open 1 to 9.»

De fleste er i stand til å ringe selv, men det er ikke alltid at det passer å ringe akkurat der og da, og for hørselshemmede er det selvfølgelig et stort problem.

Ifølge Google skal Duplex så smått begynne å bli tatt i bruk i Google Assistant i løpet av sommeren, i alle fall slik at den kan brukes til å reservere bord på restauranter, bestille frisørtime eller få opplyst åpningstidene under ferier og høytider, alt via telefonsamtaler. Nye scenarier skal legges til etter hvert.

Det er dog uklart om dette bare gjelder på engelsk, eller om det også gjelder andre språk.

Maps-nytt

Et annet produkt som skal bli betydelig forbedret framover, er Google Maps, og da spesielt appene. Blant annet skal karttjenesten i større grad kunne tilby brukertilpassede anbefalinger om det som skjer i områder brukeren er opptatt av, for eksempel når et nytt spisested legges til på kartet.

En funksjon kalt Your Match skal kombinere Googles kunnskaper om stedene på kartet med brukeranmeldelsene som bruker selv har skrevet, for så å finne fram til de stedene som stemmer best overens med brukerens egne preferanser.

Det skal også gjøres enklere for grupper å planlegge hvor man skal gå ut for å spise. En bruker kan opprette en forslagsliste direkte i Maps-appen, dele denne med andre, som kan legge til egne forslag, som alle til slutt kan stemme på.

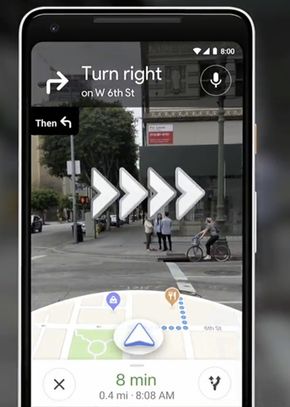

Visual Positioning System

Det å finne fram til fots på et nytt sted, kan være utfordrende, selv med Google Maps til hjelp. Spesielt kan det være vanskelig å vite i hvilken retning man står.

Google skal nå introdusere det selskapet kaller for et Visual Positioning System (VPS), hvor kameraet tas i bruk. Brukeren kan da sikte mobilen i det som antas å være den riktige retningen og få masse ny informasjon på skjermen, inkludert bedre retningsanvisninger og informasjon om stedene man passerer på veien.

De fleste av disse Maps-nyhetene skal bli tilgjengelige i løpet av sommeren.

Lens

Den nevnte VPS-funksjonaliteten bygger delvis på Google Lens, bruker objektgjenkjenning til å tilby brukeren informasjon om det som kameraet til mobilen fanger opp. I løpet av noen uker skal Lens, som er tilgjengelig på enheter med Oreo-utgaven av Android, få flere nye funksjoner.

Dette inkluderer gjenkjenning og forståelse av ord. Blant annet skal man kunne kopiere teksten fra et bilde av et gateskilt og lime det inn i for eksempel et tekstdokument.

En annen nyhet kalles for Style Match. Det kan brukes til å få tips om produkter som er i samme stil som det man har et bilde av, for eksempel en lampeskjerm eller en jakke.

Den tredje nyhetene er dog den viktigste, nemlig sanntidsresultater. Pek på noe gjenkjennelig med mobilkameraet og få umiddelbar informasjon om hva det er. Peker du kameraet mot en konsertplakat, kan Lens for eksempel foreslå en musikkvideo med den samme artisten.

Android Pancake?

Google avslørte ikke hva P-en til Android P står for under den første hovedtalen, men det er mulig det vil bli kjent senere under Google I/O. Derimot fortalte Android-sjef Dave Burke en del om ny og kanskje ikke så kjent funksjonalitet som kommer med Android P.

Også disse nyhetene er AI-drevet.

Den ene kalles for Adaptive Battery og skal kunne forbedre batteritiden til enheten med opptil 30 prosent ved å lære seg bruksmønsteret til brukeren og prioritere kjøringen av de appene og tjenestene som brukeren benytter mest.

Burke lovet også at den automatiske justeringen av lysstyrken til skjermen i Android P skal tilpasse seg bedre brukerens ønsker og dermed redusere behovene for manuell justering.

En tredje nyhet er App Actions, som skal forsøke å forutse hvilke handlinger i ulike apper brukeren kommer til å gjøre neste gang, for så å tilby snarveier til nettopp dette. Dette handler om dyplenking til funksjonaliteten i apper og krever en viss modifisering av eksisterende apper, først og fremst gjennom opprettelsen av en spesifikk XML-fil.

Ny systemnavigasjon

Navigasjonen i Android P er dessuten skiftet ut. Den virtuelle hjemknappen er nå enda mer sentral og skal brukes til det meste. Ved å skyve den sidelengs kan brukeren bla i de åpne appene. Ved å trekke den oppover kommer brukeren først til en liste med de mest brukte appene, og deretter til oversikten over alle appene.

Hvordan dette vil fungere, er vist i dette blogginnlegget.

Google er også i gang med et konsept som selskapet kaller for Digital Wellbeing. Det handler egentlig om å gjøre det enklere for brukeren å legge vekk mobilen i blant, for å konsentrere seg om viktigere ting. Ifølge Google viser undersøkelser at så mange som 70 prosent av brukerne ønsker å balansere mobiltiden sin bedre.

Noe av det Google mener vil hjelpe, er en oversikt over hvor mye tid brukeren benytter i hver av appene på enheten. Mange bruker mer tid i enkelte apper enn de kanskje er klar over. Dette kommer i Android P.

Det er også mulig å få varsler når man begynner å nærme seg den tidsbruken som man ikke ønsker å overstige.

Hysj og nedtrapping

Nytt er også en Shush-modus som ikke bare stenger ute oppringninger og meldinger, men også alle andre distraksjoner, inkludert vibrasjoner og lyder. Dette aktiveres ved å legge mobilen med skjermen ned.

Android P kommer også med Wind Down Mode, som skal hjelpe brukeren med å legge fra seg mobilen når det er sengetid. Blant annet gjøres dette ved å vise alt på skjermen i sort/hvitt. Fargene kommer først tilbake neste morgen.

Beta til en rekke enheter

Google kunngjorde for øvrig at en betaversjon av Android P nå er tilgjengelig. Ikke bare for Googles Pixel-enheter, men også for flaggskipmodeller fra sju andre leverandører. Dette inkluderer Sony Xperia XZ2, Xiaomi Mi Mix 2S, Nokia 7 Plus, Oppo R15 Pro, Vivo X21, OnePlus 6 og Essential PH‑1.

Dermed er det grunn til å tro at disse modellene også vil motta den ferdige utgaven av Android P kort tid etter at den lanseres i neste halvår. Dermed får Project Treble omsider skikkelig effekt.

Morsekode

Både Microsoft, under selskapets pågående Build-konferanse, og Google har denne uken snakket varmt om hvordan kunstig intelligens kan være til nytte for mennesker med funksjonshemminger. Et lite, men ikke ubetydelig eksempel på dette er at tastaturappen Gboard snart får betastøtte for morsekode, som kan kombineres med ordforslag.

Mennesker med for eksempel muskelsykdommer kan i noen tilfeller bare kommunisere ved hjelp av små bevegelser, noe som for eksempel kan tolkes som prikker og streker.

Fullfører setningene for deg

For funksjonsfriske brukere skal Gmail snart få støtte for det som kalles for Smart Compose. Det vil si at når brukeren begynner å skrive på en setning, vil programvaren komme med forslag til hva resten av setningen skal være. På en pc vil kan man så trykke på tabulatorknappen for at setningen skal fullføres.

Google skal rulle ut dette allerede nå i mai.

Smartere nyheter

En helt ny og smartere versjon av Google News ble lansert i dag. Den skal kunne lastes ned av alle senest i neste uke og skal blant annet bedre lære seg hva slags nyheter brukeren er interessert i å lese.

Samtidig kommer den med en Full Coverage-funksjon som skal gjøre det enkelt for brukerne å danne seg et mer komplett bilde av nyhetene, både ved at nyhetene knyttes til pålitelig informasjon om personer og steder, men også ved å det tilbys en tidslinje hvor brukerne kan følge utviklingen i saker, basert på flere ulike kilder.

I Full Coverage-delen vil alle brukerne få tilgang til den samme dekningen av sakene. Nyhetene filtreres altså ikke på brukernivå, men det sikres at alt stammer fra det Google omtaler som pålitelige kilder.

Inkludert i Google News-appen er også Subscribe with Google, som skal gjøre det enkelt for brukerne å abonnere på aviser og blader. Dette lanseres om noen uker med 60 partnere så langt. Brukerne skal få tilgang til innholdet også gjennom nettleseren.

Den første utgaven av Google News ble for øvrig lagd av en Google-ansatt like etter terrorangrep den 11. september 2001. Han ønsket å få nyheter fra flere kilder på ett sted for bedre å forstå hva som egentlig hender.

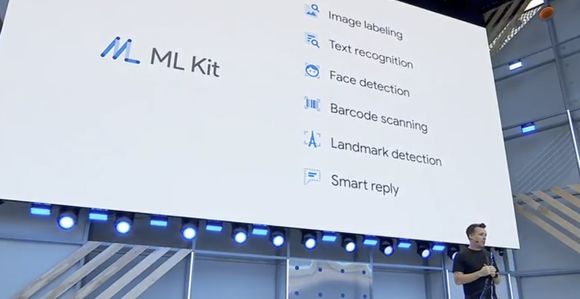

ML Kit

Den eneste virkelige utviklerrettede nyhetene under hovedtalen var lanseringen av ML Kit, en samling maskinlæringsbiblioteker som Google skal tilby gjennom Firebase. Dette skal senke terskelen for å ta i bruk mye brukt maskinlæringsfunksjonalitet og skal kunne brukes av apper til både Android og iOS.

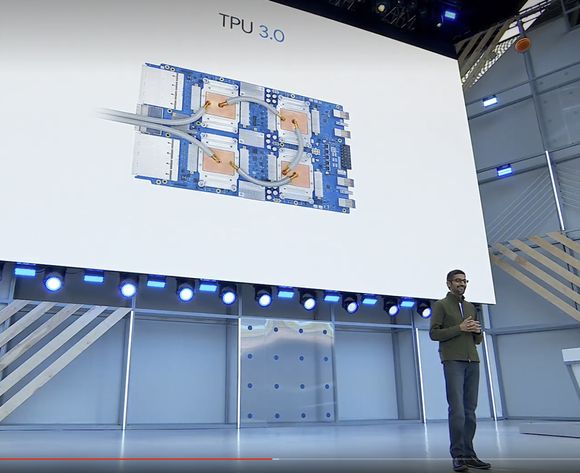

For å drive alt dette, har Google også utviklet ny maskinvare, nemlig TPU 3.0 (Tensor Processing Unit). Bruken av denne tredje generasjonen av Googles skreddersydde akselerator gjør at Google for første gang må ta i bruk væskekjøling av IT-systemene. Til gjengjeld skal den kunne levere en ytelse på over 100 petaflops, åtte ganger mer enn forrige generasjon.